дёҡеҠЎйҖ»иҫ‘

д»ҺOpenSearchдёӯжЈҖзҙўеҮәж•°жҚ®пјҢ然еҗҺеҗ„з§ҚеЎ«е……з»„иЈ…ж•°жҚ®пјҢеҗҺиҝ”еӣһ

йҖ»иҫ‘зңӢдјјеҫҲз®ҖеҚ•пјҢеҪ“еҲқжҲ‘д№ҹжҳҜиҝҷж ·и®Өдёәзҡ„пјҢдәҺжҳҜйў„дј°5еӨ©е®ҢжҲҗпјҢеҗҺеүҚеүҚеҗҺеҗҺејҖеҸ‘гҖҒиҒ”и°ғгҖҒж”№bugзӣҙеҲ°дёҠзәҝе·®дёҚеӨҡиҠұдәҶ10еӨ©пјҲеҪ“然иҝҷ10еӨ©е№¶дёҚжҳҜеҸӘеҒҡиҝҷдёҖ件дәӢжғ…пјү

еӨҚжқӮеңЁдәҺеҪұе“Қиҝ”еӣһз»“жһ„зҡ„еӣ зҙ еҫҲеӨҡпјҢжҺ’йҷӨй—®йўҳйңҖиҰҒжЈҖжҹҘй…ҚзҪ®гҖҒжЈҖжҹҘж•°жҚ®еә“гҖҒжЈҖжҹҘзј“еӯҳгҖҒжЈҖжҹҘOpenSearchгҖҒжЈҖжҹҘд»Јз Ғ

иЁҖеҪ’жӯЈдј пјҢдёҚз®ЎйҖ»иҫ‘жңүеӨҡеӨҚжқӮпјҢйғҪдёҚжҳҜдҪ йҖғйҒҝй—®йўҳзҡ„жҺҘеҸЈпјҢжӣҙдёҚжҳҜдҪ дёҚеҺ»дјҳеҢ–зҡ„зҗҶз”ұпјҢиҝҷдёҚжҳҜжң¬ж–Үзҡ„йҮҚзӮ№пјҢдјҳеҢ–иҝҮзЁӢжүҚжҳҜ

иҰҒжұӮпјҢз»ҷAPPжҸҗдҫӣзҡ„жҺҘеҸЈдёҖиҲ¬иҰҒжұӮе“Қеә”ж—¶й—ҙеңЁ100msд»ҘеҶ…

ж¬ЎеҺӢжөӢ

жғЁдёҚеҝҚзқ№пјҢе№іеқҮе“Қеә”ж—¶й—ҙ150msпјҢиҖҢдё”еңЁиҝҷж¬ЎеҺӢжөӢиҝҮзЁӢдёӯиҝҳеҸ‘зҺ°е…¶е®ғзҡ„й—®йўҳпјҢеҗҺеҸ°жҠҘй”ҷпјҢз»ҸжҹҘжҳҜOpenSearchжҜҸз§’жҹҘиҜўж¬Ўж•°йҷҗеҲ¶

дјҳеҢ–д»Јз ҒдёҺй…ҚзҪ®

1гҖҒдҝ®ж”№OpenSearchй…ҚзҪ®пјҢ并且е°ҶеҺӢжөӢзҺҜеўғдёӯзҡ„OpenSearchиҝһжҺҘең°еқҖж”№дёәеҶ…зҪ‘ең°еқҖ

2гҖҒе°Ҷд»Јз ҒдёӯеҫӘзҺҜжҹҘиҜўзј“еӯҳзҡ„ең°ж–№ж”№дёәдёҖж¬ЎжҖ§жү№йҮҸжҹҘиҜўиҝ”еӣһ

3гҖҒе’Ңзӣёе…іеҗҢеӯҰзЎ®и®ӨеҗҺеҺ»жҺүйЎ№зӣ®дёӯж— з”Ёзҡ„д»Јз Ғ

第дәҢж¬ЎеҺӢжөӢ

иҷҪ然дјҳеҢ–дәҶд»Јз ҒпјҢдҝ®ж”№дәҶй…ҚзҪ®пјҢдҪҶжҳҜжғ…еҶөжӣҙзіҹзі•дәҶпјҢиҖҢдё”иҝҳж”№еҮәдәҶж–°зҡ„й—®йўҳ

еҪ“ж—¶пјҢеҸҚеӨҚжЈҖжҹҘдәҶд»Јз ҒпјҢзЎ®е®ҡжҹҘиҜўзј“еӯҳзҡ„ж¬Ўж•°е·Із»ҸжҳҜе°‘дәҶпјҢиҖҢдё”иҝһжҺҘзәҝзЁӢжұ зӣёе…іеҸӮж•°д№ҹи°ғеҲ°дёҖдёӘзӣёеҜ№иҫғеӨ§дё”еҗҲзҗҶзҡ„еҖјдәҶ

еҰӮжһңпјҢеҶҚеҺӢжөӢиҝҳжҳҜж— жі•иҫҫеҲ°иҰҒжұӮзҡ„иҜқпјҢеҸӘжңүеҮәеҗҺдёҖжӢӣдәҶпјҡзј“еӯҳз»“жһңйӣҶ

еҚіпјҢд»Ҙз”ЁжҲ·IDе’Ңз”ЁжҲ·жҗңзҙўзҡ„е…ій”®иҜҚдёәkeyпјҢжҹҘиҜўзҡ„з»“жһңдёәvalueпјҢзј“еӯҳ5еҲҶй’ҹ

第дёүж¬ЎеҺӢжөӢ

жҖ»з®—з¬ҰеҗҲиҰҒжұӮдәҶпјҢ并еҸ‘60зҡ„ж—¶еҖҷе“Қеә”ж—¶й—ҙиҫҫеҲ°32msпјҢиҖҢжҲ‘еҸҲеҸ‘зҺ°дәҶж–°зҡ„дјҳеҢ–зӮ№

жҺҘеҸЈдёӯеұ…然иҝҳжңүжҹҘж•°жҚ®еә“зҡ„ж“ҚдҪңпјҢиҝҷеҸҜдёҚиғҪеҝҚпјҢжҺ’жҹҘд№ӢеҗҺеҺ»жҺүдәҶдёҖдәӣдёҚеҝ…иҰҒзҡ„дҫқиө–

жҲҗй•ҝ

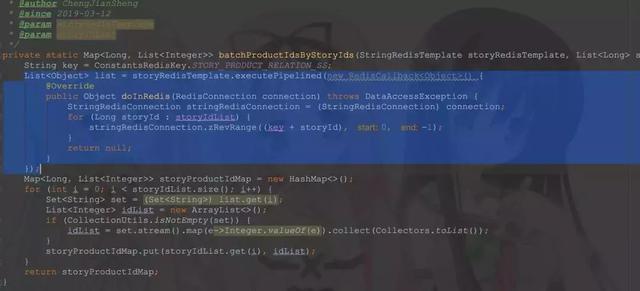

еӯҰдјҡдәҶдҪҝз”ЁRedisTemplateзҡ„executePipelinedиҝӣиЎҢredisжү№йҮҸжҹҘиҜў

й’ҲеҜ№жң¬ж¬ЎдјҳеҢ–зҡ„жҖ»з»“

1гҖҒдёҖе®ҡиҰҒйҒҝе…ҚеҫӘзҺҜжҹҘж•°жҚ®еә“е’Ңзј“еӯҳпјҲPSпјҡеҫӘзҺҜйҮҢйқўе°ұдёҚиғҪжңүжҹҘиҜўзј“еӯҳпјҢжӣҙдёҚиғҪжңүжҹҘиҜўж•°жҚ®еә“зҡ„ж“ҚдҪңпјҢеӣ дёәеҫӘзҺҜзҡ„ж¬Ўж•°жІЎжі•жҺ§еҲ¶пјү

2гҖҒеҜ№дәҺAPIжҺҘеҸЈзҡ„иҜқпјҢдёҖиҲ¬йғҪжҳҜзӣҙжҺҘжҹҘзј“еӯҳзҡ„пјҢжІЎжңүжҹҘж•°жҚ®еә“зҡ„

3гҖҒеӨҡз”Ёжү№йҮҸжҹҘиҜўпјҢе°‘з”ЁеҚ•жқЎжҹҘиҜўпјҢе°ҪйҮҸдёҖж¬ЎжҹҘеҮәжқҘ

4гҖҒеҜ№дәҺдҪҝз”ЁйҳҝйҮҢдә‘пјҢиҰҒз•ҷж„ҸдёҖдёӢзӣёеә”дә§е“Ғзҡ„й…ҚзҪ®пјҢиҜҘиҠұзҡ„й’ұиҝҳжҳҜеҫ—иҠұпјҢеҗҢж—¶пјҢеҚғдёҮиҰҒи®°еҫ—жӯЈејҸзҺҜеўғдёӯдҪҝз”Ёзӣёеә”дә§е“Ғзҡ„еҶ…зҪ‘ең°еқҖ

5гҖҒжіЁж„ҸиҝһжҺҘжұ еӨ§е°ҸпјҲеҢ…жӢ¬ж•°жҚ®еә“иҝһжҺҘжұ гҖҒRedisзј“еӯҳиҝһжҺҘжұ гҖҒзәҝзЁӢжұ пјү

6гҖҒеҺӢжөӢзҡ„жңәеҷЁдёҠдёҚиҰҒйғЁзҪІе…¶е®ғзҡ„жңҚеҠЎпјҢеҸӘи·‘еҫ…еҺӢжөӢзҡ„жңҚеҠЎпјҢйҒҝе…ҚеҸ—е…¶е®ғйЎ№зӣ®еҪұе“ҚпјӣеҜ№дәҺзәҝдёҠзҺҜеўғпјҢеҘҪдёҖеҸ°жңәеҷЁдёҠеҸӘйғЁзҪІдёҖдёӘйҮҚиҰҒзҡ„жңҚеҠЎ

7гҖҒжІЎжңүз”Ёзҡ„д»ҘеҸҠиў«жіЁйҮҠжҺүзҡ„д»Јз ҒпјҢжІЎжңүз”Ёзҡ„дҫқиө–еҘҪеҸҠж—¶жё…зҗҶжҺү

8гҖҒйӣҶзҫӨиҮӘдёҚз”ЁиҜҙ

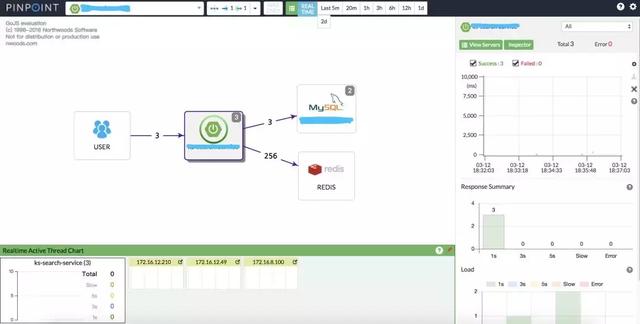

9гҖҒдёҖдәӣзӣ‘жҺ§зұ»зҡ„е·Ҙе…·е·Ҙе…·еҸҜд»Ҙеё®еҠ©жҲ‘们жӣҙеҘҪзҡ„е®ҡдҪҚй—®йўҳпјҢжҜ”еҰӮй“ҫи·Ҝи·ҹиёӘпјҢиҝҷж¬ЎйЎ№зӣ®дёӯдҪҝз”ЁдәҶPinPoint

10гҖҒеҰӮжһңжҠҖжңҜдёҠдјҳеҢ–зҡ„з©әй—ҙе·Із»Ҹйқһеёёе°ҸдәҶпјҢеҸҜд»ҘиҜ•зқҖд»ҺдёҡеҠЎдёҠзқҖжүӢпјҢз”Ёе®һйҷ…зҡ„ж•°жҚ®иҜҙиҜқпјҢеҸҜд»Ҙд»Һж—Ҙеёёзҡ„и®ҝй—®йҮҸпјҢеҺҶеҸІи®ҝй—®йҮҸж•°жҚ®жқҘиҜҙжңҚжөӢиҜ•

11гҖҒжҜҸдёҖж¬Ўд»Јз Ғж”№еҠЁйғҪжңүеҸҜиғҪеј•е…Ҙж–°зҡ„й—®йўҳпјҢеӣ жӯӨпјҢжҜҸж¬Ўдҝ®ж”№д»Јз ҒеҗҺйғҪиҰҒеӣһеҪ’жөӢиҜ•дёҖдёӢпјҲPSпјҡжҜҸж¬Ўдҝ®ж”№е®Ңд»ҘеҗҺпјҢжҲ‘йғҪдјҡз”ЁеҮ з»„дёҚеҗҢзҡ„е…ій”®иҜҚжҗңзҙўпјҢ然еҗҺжҜ”еҜ№дҝ®ж”№еүҚе’Ңдҝ®ж”№еҗҺиҝ”еӣһзҡ„ж•°жҚ®жҳҜеҗҰдёҖиҮҙпјҢиҝҷдёӘж—¶еҖҷpostmanпјҢд»ҘеҸҠBeyond compareе°ұжҙҫдёҠз”ЁеңәдәҶпјү

12гҖҒе…ій”®зҡ„ең°ж–№дёҖе®ҡиҰҒеӨҡеҠ зӮ№е„ҝж—Ҙеҝ—пјҢж–№дҫҝд»ҘеҗҺжҺ’йҷӨй—®йўҳпјҢеӣ дёәжҺ’жҹҘзәҝдёҠй—®йўҳдё»иҰҒиҝҳжҳҜйқ ж—Ҙеҝ—

еҺҹж–Үй“ҫжҺҘпјҡwww.cnblogs.com/cjsblog/p/10573215.html