1. еҶҷеңЁеүҚйқў

д№ӢеүҚзҡ„ж–Үз« жҖ»з»“дәҶдҪҝз”Ёз®ЎйҒ“иҝӣиЎҢиҝӣзЁӢй—ҙйҖҡдҝЎзҡ„ж–№жі•пјҢйҷӨдәҶpipeе’ҢfifoпјҢLinuxеҶ…ж ёиҝҳдёәжҲ‘们жҸҗдҫӣдәҶе…¶д»–жӣҙзҡ„IPCж–№ејҸпјҢеҢ…жӢ¬е…ұдә«еҶ…еӯҳпјҢж¶ҲжҒҜйҳҹеҲ—пјҢдҝЎеҸ·йҮҸзӯүпјҢжң¬зҜҮж–Үз« дјҡйҖҡиҝҮдёҖдёӘе…·жңүе®Ңж•ҙйҖ»иҫ‘еҠҹиғҪзҡ„зӨәдҫӢиҜҙжҳҺеҰӮдҪ•дҪҝз”ЁиҝҷдәӣIPCж–№жі•гҖӮжҜ•з«ҹеҚ•зәҜең°жҹҘжүӢеҶҢпјҢеҶҷд»Јз Ғ...е‘ЁиҖҢеӨҚе§ӢпјҢиҝҷдёӘиҝҮзЁӢиҝҳжҳҜжҜ”иҫғжһҜзҮҘзҡ„пјҢиҖҢ且并没жңүе“ӘдёӘIPCж–№жі•иғҪи§ЈеҶіжүҖжңүзҡ„иҝӣзЁӢй—ҙйҖҡдҝЎй—®йўҳпјҢжҜҸз§Қж–№жі•йғҪдёҚжҳҜеӯӨз«ӢеӯҳеңЁзҡ„пјҢйҖҡиҝҮдёҖдёӘе°ҸдҫӢеӯҗжҠҠе®ғ们串иҒ”иө·жқҘпјҢжҳҜдёҖз§ҚжӣҙеҘҪзҡ„еӯҰд№ ж–№ејҸгҖӮдёӢж–Үдёӯзҡ„д»Јз Ғе®һзҺ°еҸҜд»ҘеҸӮиҖғжҲ‘зҡ„д»Јз Ғд»“еә“гҖӮ

2. POSIX IPCжҰӮиҝ°

иҝӣзЁӢй—ҙйҖҡдҝЎпјҢдё»иҰҒи§ЈеҶідёӨдёӘй—®йўҳпјҢеҚіж•°жҚ®дј йҖ’е’ҢеҗҢжӯҘгҖӮPOSIX IPCжҸҗдҫӣдәҶдёӢйқўдёүз§Қж–№жі•пјҡ

- ж¶ҲжҒҜйҳҹеҲ—

- е…ұдә«еҶ…еӯҳ

- дҝЎеҸ·йҮҸ

ж“ҚдҪңзі»з»ҹдёӯиҝҗиЎҢзҡ„иҝӣзЁӢпјҢеҪјжӯӨд№Ӣй—ҙжҳҜйҡ”зҰ»зҡ„пјҢиҰҒжғіе®һзҺ°йҖҡдҝЎпјҢе°ұеҝ…йЎ»жңүдёҖдёӘеӘ’д»ӢпјҢжҳҜйҖҡдҝЎеҸҢж–№йғҪеҸҜд»Ҙи®ҝй—®еҲ°зҡ„гҖӮд»ҺиҝҷдёӘи§’еәҰзңӢпјҢж“ҚдҪңзі»з»ҹеҶ…ж ёжӯЈжҳҜжҜҸдёӘиҝӣзЁӢйғҪеҸҜд»Ҙи®ҝй—®еҲ°зҡ„йӮЈдёӘеӘ’д»ӢпјҢе°ұеғҸдёҖдёӘ"е…ЁеұҖеҸҳйҮҸ"гҖӮж¶ҲжҒҜйҳҹеҲ—дёҚиҝҮжҳҜеҶ…ж ёз»ҙжҠӨзҡ„дёҖдёӘйҳҹеҲ—пјҢдҝқеӯҳдәҶз”ЁжҲ·иҝӣзЁӢеҸ‘йҖҒжқҘзҡ„ж¶ҲжҒҜпјҢе…¶д»–иҝӣзЁӢеҸҜд»Ҙд»ҺйҳҹеҲ—дёӯеҸ–иө°ж¶ҲжҒҜпјҢжҜҸдёӘж¶ҲжҒҜеҸҜд»Ҙи®ҫзҪ®дјҳе…Ҳзә§пјҢиҝӣзЁӢеҸ‘йҖҒе’ҢжҺҘ收ж¶ҲжҒҜзҡ„иЎҢдёәеҸҜд»ҘжҳҜйҳ»еЎһжҲ–иҖ…йқһйҳ»еЎһзҡ„пјҢиҝҷдёҖзӮ№зұ»дјјз®ЎйҒ“пјӣе…ұдә«еҶ…еӯҳе°ұжҳҜеҲ©з”ЁдәҶиҷҡжӢҹең°еқҖз©әй—ҙд»ҘеҸҠзү©зҗҶең°еқҖз©әй—ҙпјҢи®©дёҚеҗҢиҝӣзЁӢзҡ„иҷҡжӢҹең°еқҖжҳ е°„еҲ°еҗҢдёҖдёӘзү©зҗҶйЎөйқўдёҠпјҢиҝҷж ·е°ұе®һзҺ°дәҶе…ұдә«пјҢеҜ№дәҺжҳ е°„зҡ„ең°еқҖз©әй—ҙеҸҜд»Ҙи®ҫе®ҡеҸҜиҜ»пјҢеҸҜеҶҷд»ҘеҸҠеҸҜжү§иЎҢзҡ„ж Үеҝ—пјӣдҝЎеҸ·йҮҸе°ұеғҸдёҖдёӘеҶ…ж ёдёӯзҡ„ж•ҙеһӢеҸҳйҮҸпјҢиҝҷдёӘеҸҳйҮҸзҡ„ж•°еҖји®°еҪ•дәҶжҹҗз§Қиө„жәҗзҡ„ж•°йҮҸпјҢиҝӣзЁӢеҸҜд»ҘеҜ№е®ғиҝӣиЎҢеҠ еҮҸж“ҚдҪңпјҢеҗҲзҗҶдҪҝз”Ёзҡ„иҜқе°ұиғҪе®ҢжҲҗжғіиҰҒзҡ„иҝӣзЁӢд№Ӣй—ҙзҡ„еҗҢжӯҘйҖ»иҫ‘гҖӮеҸҜд»ҘзңӢеҲ°пјҢиҝҷдёүз§ҚIPCж–№жі•еңЁеҶ…ж ёдёӯйғҪеҜ№еә”дәҶдёҖз§Қж•°жҚ®з»“жһ„пјҢдёәдәҶиғҪеӨҹи®©з”ЁжҲ·иҝӣзЁӢи®ҝй—®еҲ°иҝҷдәӣж•°жҚ®з»“жһ„пјҢPOSIX IPC延з»ӯдәҶвҖңдёҖеҲҮзҡҶж–Ү件вҖқзҡ„и®ҫи®ЎжҖқи·ҜпјҢжҲ‘们еҸҜд»Ҙз”Ёзұ»дјјвҖң/somenameвҖқиҝҷз§ҚеҪўејҸзҡ„ж–Ү件еҗҚеҺ»еҲӣе»әжҲ–иҖ…жү“ејҖиҝҷдәӣIPCеҜ№иұЎпјҢ然еҗҺеҜ№е®ғ们иҝӣиЎҢеҗ„з§Қж“ҚдҪңпјҢе’Ңж–Ү件зҡ„и®ҝй—®жқғйҷҗзұ»дјјпјҢиҝӣзЁӢж“ҚдҪңIPCеҜ№иұЎж—¶д№ҹдјҡиҝӣиЎҢжқғйҷҗжЈҖжҹҘгҖӮеҸҜиғҪдёҠйқўеҜ№дёүз§ҚPOSIX IPCзҡ„жҸҸиҝ°еӯҳеңЁдёҚдёҘи°Ёзҡ„ең°ж–№пјҢдҪҶеҜ№дәҺдҪҝз”ЁиҖ…жқҘиҜҙпјҢжҲ‘们еҸӘиҰҒеңЁи„‘еӯҗйҮҢе»әз«ӢдёҖдёӘеҗҲйҖӮзҡ„пјҢиғҪеӨҹжҸҸиҝ°е®ғ们е·ҘдҪңж–№ејҸзҡ„жЁЎеһӢе°ұеҸҜд»ҘдәҶпјҢиҖҢдёҚжҳҜдёҚж–ӯйҮҚеӨҚжүӢеҶҢдёӯеҜ№жҜҸдёӘapiзҡ„еҸҷиҝ°гҖӮдёӢйқўзҡ„иЎЁж јеҲ—еҮәдәҶеёёз”Ёзҡ„POSIX IPC apiпјҡ

| ж¶ҲжҒҜйҳҹеҲ— | е…ұдә«еҶ…еӯҳ | дҝЎеҸ·йҮҸ | |

|---|---|---|---|

| жү“ејҖ | mq_open | shm_open | sem_open |

| е…ій—ӯ | mq_close | shm_close | sem_close |

| ж“ҚдҪң | mq_send/mq_receive | еҶ…еӯҳиҜ»еҶҷ | sem_wait/sem_post |

| еҲ йҷӨ | mq_unlink | shm_unlink | sem_unlink |

3. POSIX IPCдҪҝз”Ё

3.1 йЎ№зӣ®еҠҹиғҪиҜҙжҳҺ

дёӢйқўе°ҶдҪҝз”Ёдёүз§ҚPOSIX IPCе®һзҺ°дёҖдёӘз®ҖеҚ•зҡ„йЎ№зӣ®пјҢз”ЁжқҘи®°еҪ•IPCзҡ„дҪҝз”Ёж–№жі•гҖӮйЎ№зӣ®еҢ…еҗ«дёҖдёӘserverиҝӣзЁӢе’ҢиӢҘе№ІдёӘclientиҝӣзЁӢпјҢ他们еҗ„иҮӘзҡ„еҠҹиғҪеҰӮдёӢпјҡ

- serverиҝӣзЁӢ

- йҰ–е…ҲиҝҗиЎҢпјҢзӯүеҫ…clientзҡ„иҝһжҺҘеҲ°жқҘпјӣ

- 收еҲ°clientзҡ„иҝһжҺҘпјҢforkеҮәдёҖдёӘж–°зҡ„иҝӣзЁӢеҺ»еӨ„зҗҶclientзҡ„иҜ·жұӮпјӣ

- clientиҝӣзЁӢ

- еҸҜд»ҘеҗҢж—¶иҝҗиЎҢеӨҡдёӘпјӣ

- еҗҜеҠЁж—¶е’Ңserverе»әз«ӢиҝһжҺҘпјҢиҝһжҺҘе»әз«Ӣе®ҢжҲҗд№ӢеҗҺпјҢжҺҘеҸ—з”ЁдәҺиҫ“е…ҘпјҢеҗ‘serverеҸ‘иө·иҜ·жұӮпјӣ

- еҸҜд»Ҙе®ҢжҲҗдё»еҠЁж–ӯејҖиҝһжҺҘпјҢз»ҲжӯўserverиҝӣзЁӢпјҢд»ҘеҸҠе…¶д»–ж“ҚдҪңпјӣ

йҰ–е…ҲеҗҜеҠЁserverиҝӣзЁӢпјҢ然еҗҺеҗҜеҠЁеӨҡдёӘclientиҝӣзЁӢеҗ‘serverеҸ‘йҖҒиҜ·жұӮпјҢйЎ№зӣ®е®һзҺ°д№ӢеҗҺзҡ„ж•ҲжһңеҰӮдёӢпјҡ

3.2 йЎ№зӣ®е®һзҺ°еҺҹзҗҶ

clientеҰӮдҪ•е’Ңserverе»әз«ӢиҝһжҺҘпјҹ

clientиҝӣзЁӢе’ҢserverиҝӣзЁӢйғҪеҸҜд»Ҙи®ҝй—®дёҖж®өе…ұдә«еҶ…еӯҳпјҢеҪ“serverиҝӣзЁӢеҗҜеҠЁж—¶пјҢдјҡеҜ№иҝҷж®өе…ұдә«еҶ…еӯҳиҝӣиЎҢеҲқе§ӢеҢ–пјҢеҲқе§ӢеҢ–е®ҢжҲҗд№ӢеҗҺпјҢserverеҜ№дҝЎеҸ·йҮҸAжү§иЎҢpostж“ҚдҪңпјҢиЎЁжҳҺе…ұдә«еҶ…еӯҳеҮҶеӨҮе®ҢжҜ•пјҢд№ӢеҗҺserverиҝӣзЁӢе°ұйҖҡиҝҮдҝЎеҸ·йҮҸBзӯүеҫ…ж–°иҝһжҺҘзҡ„е»әз«ӢпјӣеҪ“жңүж–°зҡ„clientиҝӣзЁӢжғіе»әз«ӢиҝһжҺҘж—¶пјҢдјҡе…ҲйҖҡиҝҮеҜ№дҝЎеҸ·йҮҸAжү§иЎҢwaitж“ҚдҪңпјҢзӯүеҫ…е…ұдә«еҶ…еӯҳеҸҜз”ЁпјҢеҰӮжһңеҸҜз”ЁпјҢclientдјҡжҠҠиҜ·жұӮеҸӮж•°еҶҷеҲ°е…ұдә«еҶ…еӯҳд№ӢдёӯпјҢеҶҷе…Ҙе®ҢжҲҗеҗҺдјҡеҜ№дҝЎеҸ·йҮҸBжү§иЎҢpostж“ҚдҪңпјҢйҖҡзҹҘserverиҝӣзЁӢжңүж–°зҡ„иҝһжҺҘе·Із»Ҹе»әз«ӢгҖӮ

clientе»әз«ӢиҝһжҺҘд№ӢеҗҺеҰӮдҪ•еҸ‘йҖҒиҜ·жұӮпјҹ

clientйҖҡиҝҮдёӨдёӘж¶ҲжҒҜйҳҹеҲ—е®һзҺ°еҸ‘йҖҒиҜ·жұӮе’ҢжҺҘ收е“Қеә”гҖӮеңЁclientе»әз«ӢиҝһжҺҘж—¶пјҢдјҡеңЁе…ұдә«еҶ…еӯҳдёӯеҶҷе…Ҙз”ЁдәҺе’ҢserverйҖҡдҝЎзҡ„дёӨдёӘж¶ҲжҒҜйҳҹеҲ—зҡ„еҗҚеӯ—пјҢserverеңЁеӨ„зҗҶиҝһжҺҘж—¶дјҡжү“ејҖж¶ҲжҒҜйҳҹеҲ—пјҢ然еҗҺе’ҢclientиҝӣиЎҢйҖҡдҝЎгҖӮеҜ№дәҺжҜҸдёӘж–°е»әз«Ӣзҡ„иҝһжҺҘпјҢserverдјҡforkеҮәдёҖдёӘж–°зҡ„иҝӣзЁӢеҺ»еӨ„зҗҶиҜҘиҝһжҺҘеҜ№еә”зҡ„clientеҸ‘йҖҒжқҘзҡ„иҜ·жұӮгҖӮ

clientеҰӮдҪ•йҖҡиҝҮеҸ‘йҖҒиҜ·жұӮе…ій—ӯserverпјҹ

clientйҖҡиҝҮеҗ‘иҜ·жұӮж¶ҲжҒҜйҳҹеҲ—дёӯеҶҷе…Ҙkill_serverиҜ·жұӮпјҢеҸҜд»Ҙе®һзҺ°е…ій—ӯserverгҖӮеҪ“serverиҝӣзЁӢforkеҮәзҡ„иҝӣзЁӢд»Һж¶ҲжҒҜйҳҹеҲ—дёӯиҜ»еҲ°kill_serverиҜ·жұӮпјҢиҜҘиҝӣзЁӢдјҡйҖҡиҝҮз®ЎйҒ“еҶҷе…Ҙж•°жҚ®пјҢйҖҡзҹҘserverзҡ„дё»иҝӣзЁӢз»“жқҹиҝҗиЎҢгҖӮ

serverе’Ңclientд№Ӣй—ҙзҡ„ж—¶еәҸе…ізі»пјҡ

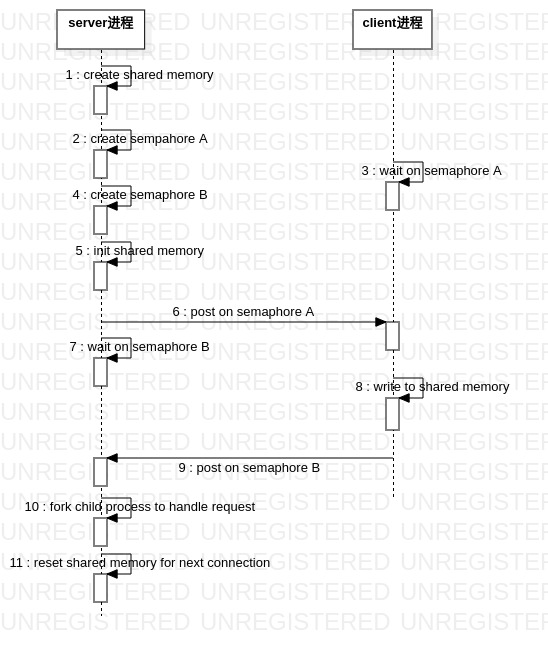

йҖҡиҝҮеүҚйқў3зӮ№зҡ„жҸҸиҝ°еҸҜд»ҘзңӢеҮәпјҢиҝҷдёӘз®ҖеҚ•зҡ„йЎ№зӣ®еҮ д№Һз”ЁеҲ°дәҶе…ЁйғЁеёёз”Ёзҡ„IPCж–№жі•пјҢдёӢйқўиҝҷдёӘж—¶еәҸеӣҫжӣҙзӣҙи§Ӯең°иҜҙжҳҺдәҶе…¶е·ҘдҪңеҺҹзҗҶпјҡ

serverе’Ңclientд№Ӣй—ҙзҡ„еҗҢжӯҘж“ҚдҪңдё»иҰҒйӣҶдёӯеңЁжӯҘйӘӨ6,7,8,9гҖӮеҪ“serverеҮҶеӨҮеҘҪе…ұдә«еҶ…еӯҳд№ӢеҗҺпјҢйҖҡиҝҮ第6жӯҘзҡ„дҝЎеҸ·йҮҸAйҖҡзҹҘclientеҸҜд»Ҙе»әз«ӢиҝһжҺҘдәҶпјҢд№ӢеҗҺclientеҗ‘е…ұдә«еҶ…еӯҳеҶҷе…Ҙж•°жҚ®пјҢеҶҚж“ҚдҪң第9жӯҘзҡ„дҝЎеҸ·йҮҸBйҖҡзҹҘserverиҝһжҺҘж•°жҚ®е·Із»ҸеҶҷе…ҘпјҢеҗҺserverдјҡеҲӣе»әеӯҗиҝӣзЁӢеҺ»еӨ„зҗҶclientзҡ„иҜ·жұӮгҖӮе®һйҷ…дёҠserverзҡ„дё»иҝӣзЁӢжҳҜдёҖдёӘеҫӘзҺҜпјҢеӨ„зҗҶиҜ·жұӮйғҪжҳҜеңЁserverзҡ„еӯҗиҝӣзЁӢдёӯе®ҢжҲҗзҡ„пјҢд»ҘдёҠеҶ…е®№иҜҙжҳҺдәҶserverдё»иҝӣзЁӢеңЁеҫӘзҺҜдёӯе®ҢжҲҗзҡ„е·ҘдҪңгҖӮ

иө„жәҗжё…зҗҶ

еҪ“жҲ‘们дҪҝз”ЁPOSIX IPCж—¶пјҢеҶ…ж ёдјҡе»әз«Ӣзӣёеә”зҡ„ж•°жҚ®з»“жһ„пјҢ并且йҖҡиҝҮж–Ү件系з»ҹжҺҘеҸЈеұ•зӨәз»ҷз”ЁжҲ·пјҢдҪҶIPCиө„жәҗдёҚиғҪж— йҷҗеҲӣе»әпјҢеҪ“жҲ‘们зҡ„зЁӢеәҸиҝҗиЎҢз»“жқҹд№ӢеҗҺеә”иҜҘжё…зҗҶиҮӘе·ұз”ЁеҲ°зҡ„IPCиө„жәҗгҖӮиҝҗиЎҢзЁӢеәҸж—¶еҲӣе»әзҡ„POSIX IPCеҜ№иұЎеҸҜд»ҘеңЁ/dev/shmд»ҘеҸҠ/dev/mqueueдёӢжҹҘзңӢпјҢзЁӢеәҸз»“жқҹд№ӢеҗҺпјҢserverе’ҢclientдјҡйҮҠж”ҫжҺүиҮӘе·ұеҲӣе»әзҡ„IPCиө„жәҗгҖӮжүҖд»ҘпјҢиҰҒжҹҘзңӢserverе’ҢclientеҲӣе»әзҡ„е…ұдә«еҶ…еӯҳпјҢдҝЎеҸ·йҮҸд»ҘеҸҠж¶ҲжҒҜйҳҹеҲ—пјҢйңҖиҰҒеңЁзЁӢеәҸиҝҗиЎҢжңҹй—ҙжҹҘзңӢдёҠиҝ°зҡ„дёӨдёӘзӣ®еҪ•гҖӮ

3.3 дё»иҰҒд»Јз ҒеҠҹиғҪ

ж¶ҲжҒҜж јејҸпјҡ

serverе’Ңclientд№Ӣй—ҙйҖҡиҝҮж¶ҲжҒҜйҳҹеҲ—дј йҖ’иҜ·жұӮе’Ңе“Қеә”ж•°жҚ®пјҢж¶ҲжҒҜйҳҹеҲ—дёӯж¶ҲжҒҜж јејҸе®ҡд№үеҰӮдёӢпјҡ

struct msgbuf { int type; union { struct { int a; int b; } request_add; struct { int c; } response_add; struct { int disconect; } request_disconnect; struct { int kill_server; } request_kill_server; } data; };serverдё»иҝӣзЁӢпјҡ

int main(int argc, char **argv) { int err = server_init(); if (err) { log_warning("server_init failed\n"); return -1; } server_start(); server_shutdown(); return ; }е…¶дёӯпјҢеңЁserver_initдёӯпјҢserverдјҡеҲӣе»әйңҖиҰҒдҪҝз”Ёзҡ„е…ұдә«еҶ…еӯҳпјҢдҝЎеҸ·йҮҸд»ҘеҸҠз®ЎйҒ“гҖӮ

int server_init() { memset(&ipc_server, , sizeof(ipc_server)); // shared memory init ipc_server.conn_buf_fd = shm_open(CONNECTION_SHM, O_CREAT | O_RDWR, S_IRUSR | S_IWUSR); ... if (ftruncate(ipc_server.conn_buf_fd, CONNECTION_SHM_SIZE) < ) { log_warning("server failed ftruncate\n"); return -1; } ipc_server.conn_buf = (struct connection *)mmap( NULL, CONNECTION_SHM_SIZE, PROT_READ | PROT_WRITE, MAP_SHARED, ipc_server.conn_buf_fd, ); ... memset(ipc_server.conn_buf, , CONNECTION_SHM_SIZE); ipc_server.conn_buf_ready = sem_open(CONNECTION_BUF_SEM, O_CREAT | O_RDWR, S_IRUSR | S_IWUSR, ); ... ipc_server.conn_new_ready = sem_open(CONNECTION_NEW_SEM, O_CREAT | O_RDWR, S_IRUSR | S_IWUSR, ); ... // pipe init int pipefd[2]; if (pipe2(ipc_server.pipefd, O_NONBLOCK)) { log_warning("server failed pipe2\n"); return -1; } log_info("server init done\n"); return ; }еңЁserver_startдёӯдјҡеҫӘзҺҜеӨ„зҗҶжқҘиҮӘclientзҡ„иҝһжҺҘгҖӮ

void server_start() { int err = sem_post(ipc_server.conn_buf_ready); ... struct connection conn; int stop = ; while (!stop) { // handle new connection sem_wait(ipc_server.conn_new_ready); if (read(ipc_server.pipefd[], &stop, sizeof(int)) <= ) stop = ; if (ipc_server.conn_buf->valid) { log_info("new connection established\n"); memcpy(&conn, ipc_server.conn_buf, sizeof(conn)); handle_connection(&conn); memset(ipc_server.conn_buf, , sizeof(struct connection)); sem_post(ipc_server.conn_buf_ready); } } }еҪ“serverдё»иҝӣзЁӢйҖҖеҮәд№ӢеҗҺпјҢserver_shutdownдјҡжё…зҗҶIPCиө„жәҗгҖӮ

clientиҝӣзЁӢпјҡ

clientеҗҜеҠЁд№ӢеҗҺпјҢйҰ–е…Ҳдјҡе°қиҜ•е’Ңserverе»әз«ӢиҝһжҺҘпјҢе»әз«ӢиҝһжҺҘд№ӢеҗҺдјҡеҫӘзҺҜеӨ„зҗҶз”ЁжҲ·иҫ“е…ҘпјҢйҖҡиҝҮж¶ҲжҒҜйҳҹеҲ—еҗ‘serverзҡ„жңҚеҠЎиҝӣзЁӢеҸ‘йҖҒиҜ·жұӮгҖӮ

int main(int argc, char **argv) { if (build_connection()) { log_info("client failed build_connection\n"); return -1; } handle_command(); cleanup(); log_info("client %d exit\n", getpid()); return ; }clientе»әз«ӢиҝһжҺҘзҡ„иҝҮзЁӢеҰӮдёӢпјҡе»әз«ӢиҝһжҺҘж—¶clientйңҖиҰҒзӯүеҫ…е…ұдә«еҶ…еӯҳеҸҜз”ЁпјҢ并且еңЁеҶҷе…ҘиҝһжҺҘж•°жҚ®д№ӢеҗҺйҖҡзҹҘserverпјҢиҝҷдәӣеҗҢжӯҘж“ҚдҪңйғҪжҳҜйҖҡиҝҮдҝЎеҸ·йҮҸе®һзҺ°зҡ„гҖӮ

int build_connection() { ... connection.mqreq_fd = mq_open(connection.mqreq, O_CREAT | O_RDWR, S_IRUSR | S_IWUSR, &attr); connection.mqrsp_fd = mq_open(connection.mqrsp, O_CREAT | O_RDWR, S_IRUSR | S_IWUSR, &attr); ... // open and map shared memory int fd = shm_open(CONNECTION_SHM, O_RDWR, ); void *conn_buf = mmap(NULL, CONNECTION_SHM_SIZE, PROT_READ | PROT_WRITE, MAP_SHARED, fd, ); // write connection to conn_buf, notify server new conncection is comming sem_t *conn_buf_ready = sem_open(CONNECTION_BUF_SEM, O_RDWR); sem_t *conn_new_ready = sem_open(CONNECTION_NEW_SEM, O_RDWR); ... sem_wait(conn_buf_ready); connection.valid = 1; memcpy(conn_buf, &connection, sizeof(connection)); sem_post(conn_new_ready); ... return ; }

еҶҷеңЁеҗҺ

йҖҡиҝҮдёҖдёӘеҢ…еҗ«serverе’Ңclientзҡ„д»Јз ҒзӨәдҫӢпјҢиҜҙжҳҺдәҶPOSIX IPCдёӯ*е…ұдә«еҶ…еӯҳпјҢж¶ҲжҒҜйҳҹеҲ—д»ҘеҸҠдҝЎеҸ·йҮҸзҡ„дҪҝз”Ёж–№жі•гҖӮе…·дҪ“е®һзҺ°еҸҜд»ҘеҸӮиҖғжҲ‘зҡ„д»Јз Ғд»“еә“гҖӮ