来自:cnblogs.com/Finley/p/16400287.html

当订单一直处于未支付状态时,如何及时的关闭订单,并退还库存? 新创建店铺,N天内没有上传商品,系统如何知道该信息,并发送激活短信?

DelayQueue 等方式实现延时任务。我们在之前的文章中讨论过他们的缺陷:比如使用 Redis 过期通知不保证准时、发送即忘不保证送达,时间轮缺乏持久化机制容易丢失等。持久化: 服务重启或崩溃不能丢失任务 确认重试机制: 任务处理失败或超时应该有重试 定时尽量

member 投递时间戳作为 score,使用 zrangebyscore 命令搜索已到投递时间的消息然后将其发给消费者。提供 ACK 和重试机制 只需要 Redis 和消费者即可运行,无需其它组件 提供 At-Least-One 投递语义、并保证消息不会并发消费

https://github.com/HDT3213/delayqueue

go get github.com/hdt3213/delayqueue 完成安装。start() 即可:package main

import (

"github.com/go-redis/redis/v8"

"github.com/hdt3213/delayqueue"

"strconv"

"time"

)

func main() {

redisCli := redis.NewClient(&redis.Options{

Addr: "127.0.0.1:6379",

})

queue := delayqueue.NewQueue("example-queue", redisCli, func(payload string) bool {

// 注册处理消息的回调函数

// 返回 true 表示已成功消费,返回 false 消息队列会重新投递次消息

return true

})

// 发送延时消息

for i := ; i < 10; i++ {

err := queue.SendDelayMsg(strconv.Itoa(i), time.Hour, delayqueue.WithRetryCount(3))

if err != nil {

panic(err)

}

}

// 启动消费协程

done := queue.StartConsume()

// 阻塞等待消费协程退出

<-done

}

原理详解

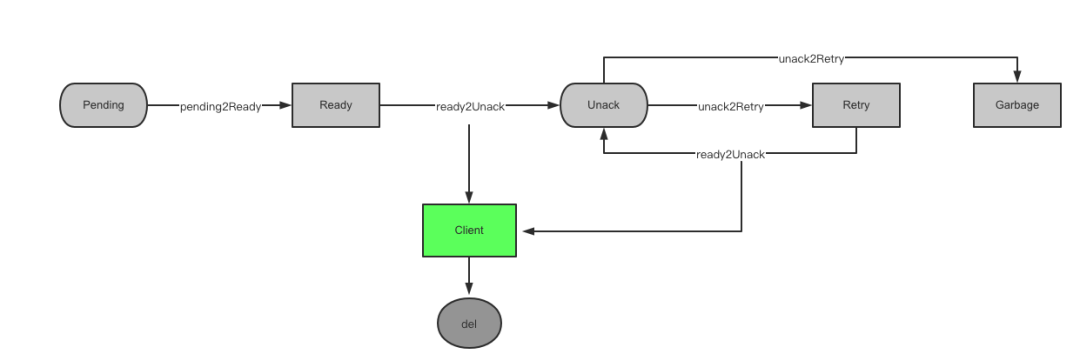

msgKey: 为了避免两条内容完全相同的消息造成意外的影响,我们将每条消息放到一个字符串类型的键中,并分配一个 UUID 作为它的标识。其它数据结构中只存储 UUID 而不存储完整的消息内容。每个 msg 拥有一个独立的 key 而不是将所有消息放到一个哈希表是为了利用 TTL 机制避免pendingKey: 有序集合类型,member 为消息 ID, score 为投递时间的 unix 时间戳。readyKey: 列表类型,需要投递的消息 ID。unAckKey: 有序集合类型,member 为消息 ID, score 为重试时间的 unix 时间戳。retryKey: 列表类型,已到重试时间的消息 IDgarbageKey: 集合类型,用于暂存已达重试上线的消息 IDretryCountKey: 哈希表类型,键为消息 ID, 值为剩余的重试次数

都是原子性的 不会重复处理同一条消息 操作前后消息队列始终处于正确的状态

pending2ReadyScript

pending2ReadyScript 使用 zrangebyscore 扫描已到投递时间的消息ID并把它们移动到 ready 中:-- keys: pendingKey, readyKey

-- argv: currentTime

local msgs = redis.call('ZRangeByScore', KEYS[1], '0', ARGV[1]) -- 从 pending key 中找出已到投递时间的消息

if (#msgs == 0) then return end

local args2 = {'LPush', KEYS[2]} -- 将他们放入 ready key 中

for _,v in ipairs(msgs) do

table.insert(args2, v)

end

redis.call(unpack(args2))

redis.call('ZRemRangeByScore', KEYS[1], '0', ARGV[1]) -- 从 pending key 中删除已投递的消息

ready2UnackScript

ready2UnackScript 从 ready 或者 retry 中取出一条消息发送给消费者并放入 unack 中,类似于 RPopLPush:-- keys: readyKey/retryKey, unackKey

-- argv: retryTime

local msg = redis.call('RPop', KEYS[1])

if (not msg) then return end

redis.call('ZAdd', KEYS[2], ARGV[1], msg)

return msg

unack2RetryScript

unack2RetryScript 从 retry 中找出所有已到重试时间的消息并把它们移动到 unack 中:-- keys: unackKey, retryCountKey, retryKey, garbageKey

-- argv: currentTime

local msgs = redis.call('ZRangeByScore', KEYS[1], '0', ARGV[1]) -- 找到已到重试时间的消息

if (#msgs == 0) then return end

local retryCounts = redis.call('HMGet', KEYS[2], unpack(msgs)) -- 查询剩余重试次数

for i,v in ipairs(retryCounts) do

local k = msgs[i]

if tonumber(v) > then -- 剩余次数大于 0

redis.call("HIncrBy", KEYS[2], k, -1) -- 减少剩余重试次数

redis.call("LPush", KEYS[3], k) -- 添加到 retry key 中

else -- 剩余重试次数为 0

redis.call("HDel", KEYS[2], k) -- 删除重试次数记录

redis.call("SAdd", KEYS[4], k) -- 添加到垃圾桶,等待后续删除

end

end

redis.call('ZRemRangeByScore', KEYS[1], '0', ARGV[1]) -- 将已处理的消息从 unack key 中删除

KEYS 参数中声明自己要访问的 key, 而我们将每个 msg 有一个独立的 key,我们在执行 unack2RetryScript 之前是不知道哪些 msg key 需要被删除。所以 lua 脚本只将需要删除的消息记在 garbage key 中,脚本执行完后再通过 del 命令将他们删除:func (q *DelayQueue) garbageCollect() error {

ctx := context.Background()

msgIds, err := q.redisCli.SMembers(ctx, q.garbageKey).Result()

if err != nil {

return fmt.Errorf("smembers failed: %v", err)

}

if len(msgIds) == {

return nil

}

// allow concurrent clean

msgKeys := make([]string, , len(msgIds))

for _, idStr := range msgIds {

msgKeys = append(msgKeys, q.genMsgKey(idStr))

}

err = q.redisCli.Del(ctx, msgKeys...).Err()

if err != nil && err != redis.Nil {

return fmt.Errorf("del msgs failed: %v", err)

}

err = q.redisCli.SRem(ctx, q.garbageKey, msgIds).Err()

if err != nil && err != redis.Nil {

return fmt.Errorf("remove from garbage key failed: %v", err)

}

return nil

}

ack

func (q *DelayQueue) ack(idStr string) error {

ctx := context.Background()

err := q.redisCli.ZRem(ctx, q.unAckKey, idStr).Err()

if err != nil {

return fmt.Errorf("remove from unack failed: %v", err)

}

// msg key has ttl, ignore result of delete

_ = q.redisCli.Del(ctx, q.genMsgKey(idStr)).Err()

q.redisCli.HDel(ctx, q.retryCountKey, idStr)

return nil

}

unack key 中消息的重试时间改为现在,随后执行的 unack2RetryScript 会立即将它移动到 retry keyfunc (q *DelayQueue) nack(idStr string) error {

ctx := context.Background()

// update retry time as now, unack2Retry will move it to retry immediately

err := q.redisCli.ZAdd(ctx, q.unAckKey, &redis.Z{

Member: idStr,

Score: float64(time.Now().Unix()),

}).Err()

if err != nil {

return fmt.Errorf("negative ack failed: %v", err)

}

return nil

}

consume

consume 函数,它负责调用上述脚本将消息转移到正确的集合中并回调 consumer 来消费消息:func (q *DelayQueue) consume() error {

// 执行 pending2ready,将已到时间的消息转移到 ready

err := q.pending2Ready()

if err != nil {

return err

}

// 循环调用 ready2Unack 拉取消息进行消费

var fetchCount uint

for {

idStr, err := q.ready2Unack()

if err == redis.Nil { // consumed all

break

}

if err != nil {

return err

}

fetchCount++

ack, err := q.callback(idStr)

if err != nil {

return err

}

if ack {

err = q.ack(idStr)

} else {

err = q.nack(idStr)

}

if err != nil {

return err

}

if fetchCount >= q.fetchLimit {

break

}

}

// 将 nack 或超时的消息放入重试队列

err = q.unack2Retry()

if err != nil {

return err

}

// 清理已达到大重试次数的消息

err = q.garbageCollect()

if err != nil {

return err

}

// 消费重试队列

fetchCount =

for {

idStr, err := q.retry2Unack()

if err == redis.Nil { // consumed all

break

}

if err != nil {

return err

}

fetchCount++

ack, err := q.callback(idStr)

if err != nil {

return err

}

if ack {

err = q.ack(idStr)

} else {

err = q.nack(idStr)

}

if err != nil {

return err

}

if fetchCount >= q.fetchLimit {

break

}

}

return nil

}