1.简单介绍负载均衡

如果你的nginx服务器给2台web服务器做代理,负载均衡算法采用轮询,那么当你的一台机器web程序关闭造成web不能访问,那么nginx服务器分发请求还是会给这台不能访问的web服务器,如果这里的响应连接时间过长,就会导致客户端的页面一直在等待响应,对用户来说体验就打打折扣,这里我们怎么避免这样的情况发生呢。这里我配张图来说明下问题。

如果负载均衡中其中web2发生这样的情况,nginx首先会去web1请求,但是nginx在配置不当的情况下会继续分发请求到web2,然后等待web2响应,直到我们的响应时间超时,才会把请求重新分发给web1,这里的响应时间如果过长,用户等待的时间就会越长。

2.准备工作

三台装有nginx的虚拟机,一台做反向代理服务器,另外两台做真实服务器,模拟负载均衡。

192.168.13.129 #反向代理服务器

192.168.13.133 #真实服务器

192.168.13.139 #真实服务器3.三台服务器的配置

我们在反向代理服务器上(192.168.13.139)进行如下配置:

[root@real-server ~]# vim /etc/nginx/conf.d/default.conf

清空并添加以下内容

upstream test_server {

server 192.168.13.133:8080;

server 192.168.13.139:8080;

}

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://test_server;

}

}

[root@server ~]# nginx -t

[root@server ~]# nginx -s reload

台真实服务器配置(192.168.13.133):

[root@real-server ~]# vim /etc/nginx/conf.d/default.conf

清空并添加以下内容

server {

listen 80;

server_name localhost;

location / {

root /usr/share/nginx/html/login;

index index.html index.html;

}

}

[root@real-server ~]# nginx -t

[root@real-server ~]# nginx -s reload

#创建目录和文件并写入测试数据

[root@real-server ~]# mkdir -p /usr/share/nginx/html/login

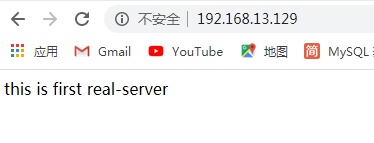

[root@real-server ~]# echo "this is first real-server" > /usr/share/nginx/html/login/index.html

第二台真实服务器配置(192.168.13.139):

[root@real-server ~]# vim /etc/nginx/conf.d/default.conf

清空并添加以下内容

server {

listen 80;

server_name localhost;

location / {

root /usr/share/nginx/html/login;

index index.html index.html;

}

}

[root@real-server ~]# nginx -t

[root@real-server ~]# nginx -s reload

#创建目录和文件并写入测试数据

[root@real-server ~]# mkdir -p /usr/share/nginx/html/login

[root@real-server ~]# echo "this is second real-server" > /usr/share/nginx/html/login/index.html测试:打开网页输入反向代理服务器ip:http://192.168.13.129/

刷新一下

4.负载均衡算法

upstream 支持4种负载均衡调度算法:

A、轮询(默认):每个请求按时间顺序逐一分配到不同的后端服务器;

B、ip_hash:每个请求按访问IP的hash结果分配,同一个IP客户端固定访问一个后端服务器。可以保证来自同一ip的请求被打到固定的机器上,可以解决session问题。

C、url_hash:按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器。后台服务器为缓存的时候效率。

D、fair:这是比上面两个更加智能的负载均衡算法。此种算法可以依据页面大小和加载时间长短智能地进行负载均衡,也就是根据后端服务器的响应时间来分配请求,响应时间短的优先分配。Nginx本身是不支持 fair的,如果需要使用这种调度算法,必须下载Nginx的 upstream_fair模块。

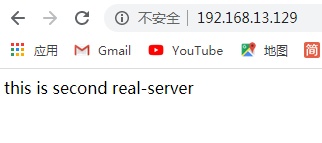

配置实例 1、热备:如果你有2台服务器,当台服务器发生事故时,才启用第二台服务器给提供服务。

upstream test_server {

server 192.168.13.133:80;

server 192.168.13.139:80 backup;

}然后再次访问方向代理服务器ip

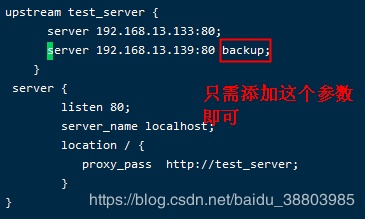

2.轮询:nginx默认就是轮询其权重都默认为1,服务器的访问顺序就是台服务器,第二台,台,第二台然后再次循环(因为默认是轮询,所以不需要加任何参数) 3、加权轮询:跟据配置的权重的大小而分发给不同服务器不同数量的请求。如果不设置,则默认为1。

upstream test_server {

server 192.168.13.133:80 weight=1;

server 192.168.13.139:80 weight=3;

}4、ip_hash:nginx会让相同的客户端ip请求相同的服务器。

upstream test_server {

server 192.168.13.133:80;

server 192.168.13.139:80;

ip_hash;

}5、nginx负载均衡配置状态参数

- down,表示当前的server暂时不参与负载均衡。

- backup,预留的备份机器。当其他所有的非backup机器出现故障或者忙的时候,才会请求backup机器,因此这台机器的压力轻。

- max_fails,允许请求失败的次数,默认为1。当超过大次数时,返回错误。

- fail_timeout,在经历了max_fails次失败后,暂停服务的时间单位秒。max_fails可以和fail_timeout一起使用。

upstream test_server {

server 192.168.13.133:80 weight=2 max_fails=2 fail_timeout=2;

#加权轮询的权值是2,允许请求失败两次,然后暂停服务两秒

server 192.168.13.139:80 weight=3 max_fails=3 fail_timeout=3;

#加权轮询的权值是3,允许请求失败三次,然后暂停服务三秒

}你们的评论和点赞是我写文章的大动力,蟹蟹。